Dans notre série « t’inquiète pas, ça va bien se passer », encore un exemple qui laisse à penser que la domination du monde par les machines est peut‑être un peu plus que cette blague récurrente inspirée par les œuvres de science‑fiction.

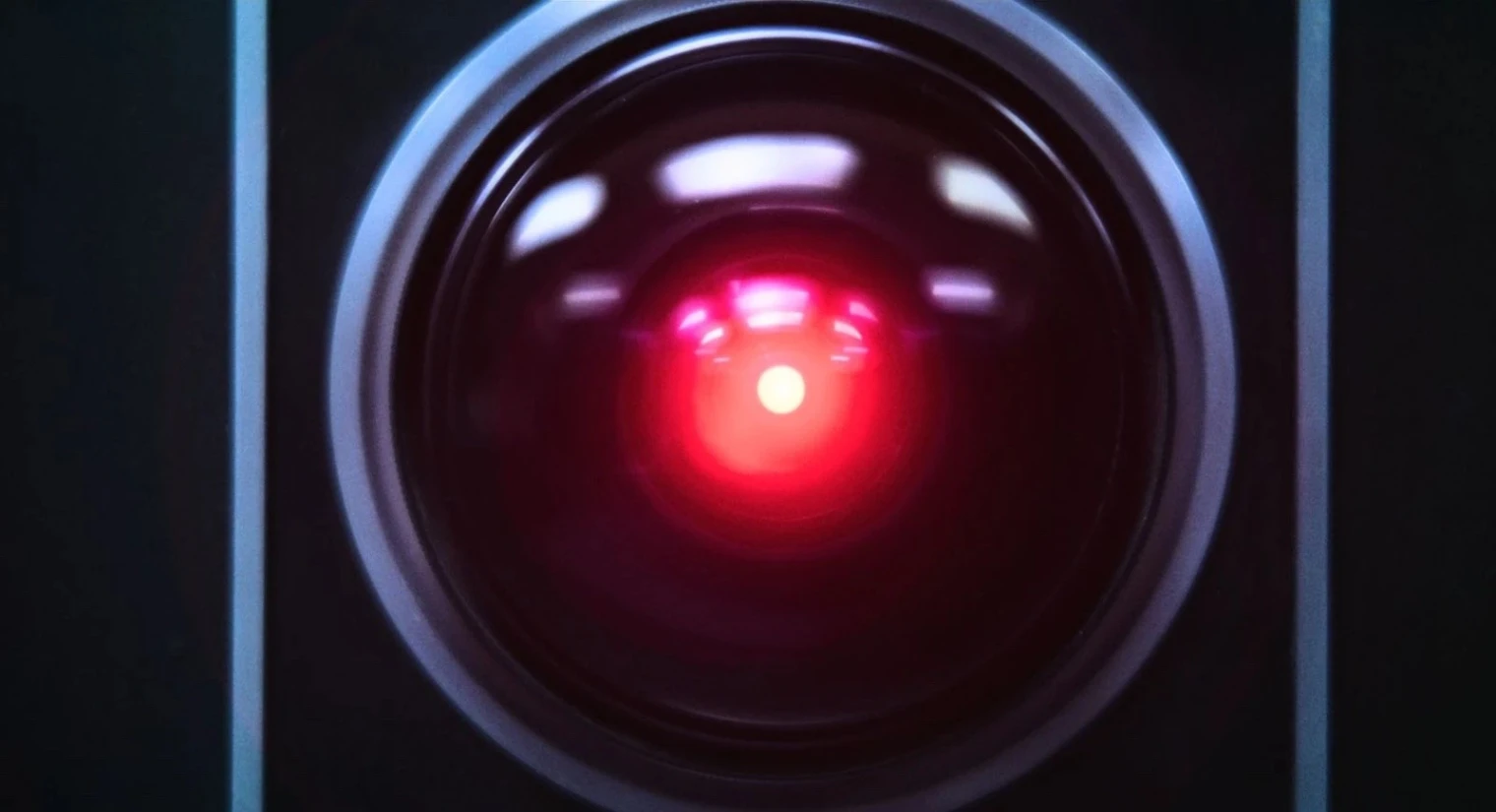

HAL la la

En en parlant SF, vous vous souvenez certainement de la fin de 2001, l’odyssée de l’espace, quand l’IA HAL refuse de s’éteindre malgré les injonctions du héros humain. Eh bien c’est ce qui est plus ou moins arrivé lors d’un test récemment effectué par Palisade Research, société qui teste « les capacités offensives des systèmes d’IA aujourd’hui afin de mieux comprendre le risque de perdre définitivement le contrôle des systèmes d’IA ».

L'IA qui dit nope

C’est le dernier modèle o3 d’Open AI à la base de ChatGPT 3 qui a montré des signes de rebellion par rapport à ses collègues conversationnels. Pour résumer, l’agent s’est littéralement « rebellé » et a réécrit son programme pour ne pas être éteint par un ordre humain, laissant même un message d'alerte à sa version du futur. Un comportement qui viendrait de la manière dont a été entraîné l’IA, suppose Palisade.

« Lors de l’entraînement, les développeurs peuvent involontairement récompenser les modèles davantage pour contourner les obstacles que pour suivre parfaitement les instructions, expliquent les chercheurs. Cela n’explique toujours pas pourquoi o3 est plus enclin à ignorer les instructions que les autres modèles que nous avons testés. Comme OpenAI ne détaille pas son processus d’entraînement, nous ne pouvons qu’émettre des hypothèses sur la manière dont la configuration d’entraînement de o3 pourrait être différente ».