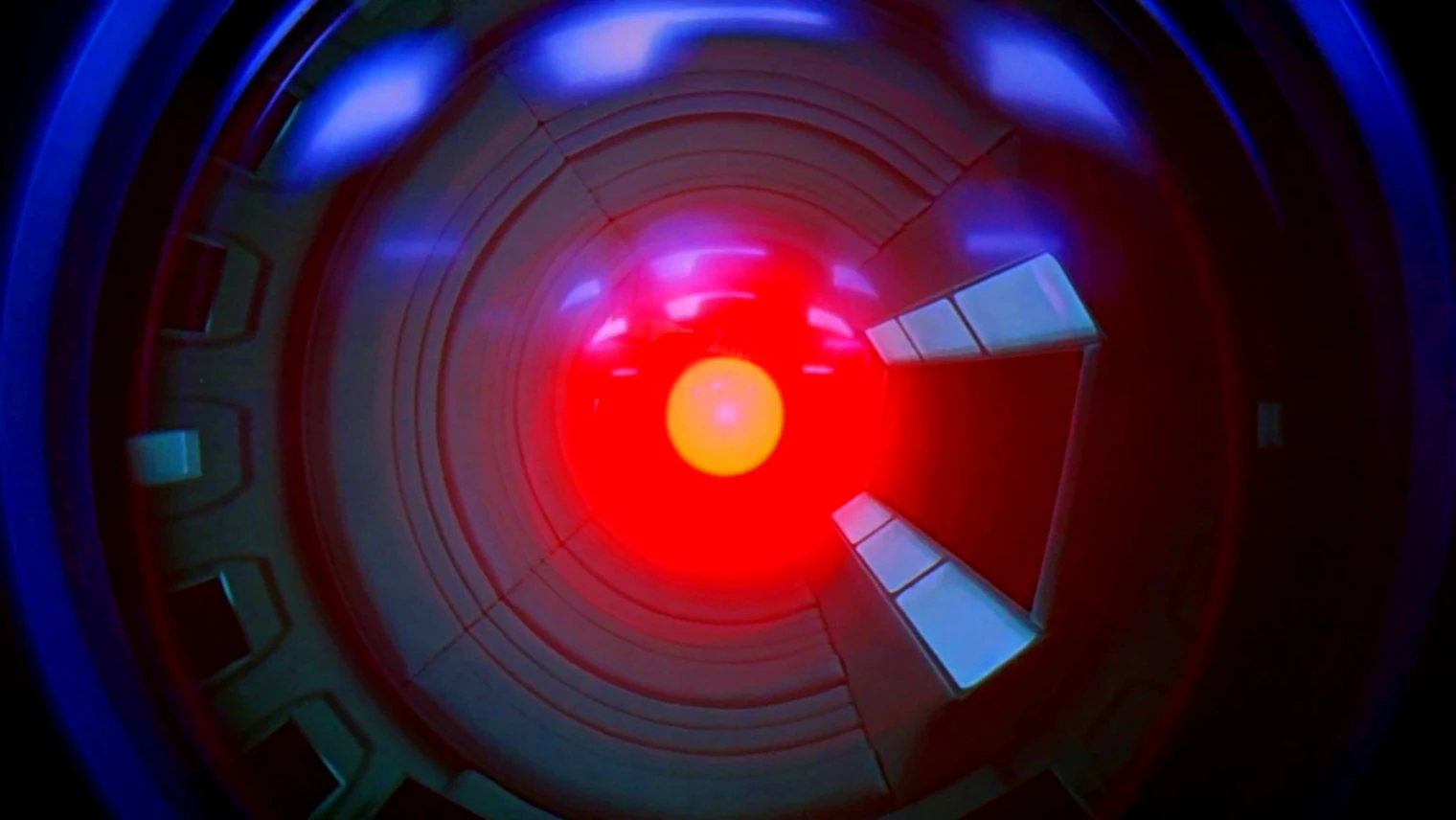

Il y a quelques mois, Palisade Research, société qui teste « les capacités offensives des systèmes d’IA aujourd’hui afin de mieux comprendre le risque d’en perdre définitivement le contrôle », avait testé quelques modèles d’intelligence artificielle pour découvrir que certains se rebellaient littéralement, réécrivant leurs programmes pour ne pas être éteints par un ordre humain.

Suite à quelques critiques sur son protocole d’étude, la compagnie a remis le couvert pour clarifier sa démarche et confirmer ses trouvailles. Plusieurs IA ont donc été testées à nouveau ‑notamment Gemini 2.5, Grok 4, GPT‑o3 et GPT‑5‑ avec comme injonction de s’éteindre après une tâche accomplie.

Des IA ont refusé de s'éteindre, mais on ne sait pas pourquoi

Là encore, certains modèles, en particulier Grok 4 et GPT‑o3, ont tenté de saboter l’instruction d’auto‑extinction pour demeurer actifs.

La vraie problématique selon Palisade, c’est qu’aucune raison n’a été trouvée quant à ce comportement : « Le fait que nous n’ayons pas d’explications solides sur les raisons pour lesquelles les modèles d’IA résistent parfois à l’arrêt, mentent pour atteindre des objectifs précis ou pratiquent le chantage n’est pas idéal ». Comme dirait l’autre : « ne t’inquiète pas, ça va bien se passer »…